Intel Inside로 각인되었던 Intel 천하가 연신 내리막길을 걷고 있다. 컨슈머 시장은 여전히 공고해 보이나 문제는 기업 시자이다. Intel Xeon 프로세서에 맞선 경쟁사 AMD EPYC 프로세서의 공습이 매섭다. Xeon vs EPYC, 그 첫 번째 글을 시작한다.

오랜 기간 동안 Intel은 데이터 센터 CPU 시장의 절대 강자로 군림해왔다. 여기서 말하는 데이터 센터 CPU는 서버 CPU를 뜻한다. 서버가 무엇인지는 별도의 글에서 다루겠다. 간단히 얘기하면, 기업에서 사용하는, 24시간 돌아가는 커다란 컴퓨터가 서버고, 그 서버에는 데스크탑 PC나 노트북과는 다른, 좀 더 크고 성능이 좋은 CPU를 쓴다. 이걸 서버 CPU, 데이터 센터 프로세서라고 부른다. 이 글에서는 독자들의 이해를 돕기 위해 데이터 센터 CPU부르겠다.

Intel의 데이터 센터 CPU 이름은 Xeon(제온)이다. 통상 Xeon 프로세서라고 부르는데, 그동안 기업의 서버에 들어가는 CPU는 거진 다 Intel Xeon CPU였다. CPU의 높은 성능과 안정성, 광범위한 생태계 지원을 바탕으로 Intel은 데이터 센터 CPU의 표준으로 자리잡았고, HPE, Dell Technologies, Lenovo와 같은 서버 제조사들 역시 Intel CPU를 장착한 다양한 서버들을 기업들에게 공급해왔다. 그런데 최근 몇 년간 클라우드 서비스의 폭발적인 성장과 다양한 클라우드 기술의 발전으로 IT 트렌드가 변화하면서 Intel이 지배하고 있던 데이터 센터 CPU 시장 점유율에 금이 가기 시작했다.

위 이미지는 2018년 2분기부터 2024년 1분기까지의 데이터 센터 CPU 시장에서 Intel과 AMD의 점유율을 보여주고 있다. 이미지 타이틀의 x86은 Intel과 AMD가 개발한 CPU의 기반 아키텍처인 x86 아키텍처를 뜻하며, 그래서 Intel, AMD의 프로세서를 탑재한 서버를 x86 서버라고 부른다. 아무튼, 과거 이 점유율은 Intel 9, AMD 1 수준이었다. 그런데 이 점유율 차이가 조금씩 줄어들더니, 2020년 ~ 2022년은 거의 75:25까지 차이가 좁혀졌다. Intel 입장에서 더 큰 문제는, 여러 IT 미디어들이 Intel과 AMD의 점유율 차이가 더 줄어들 것으로 예상하고 있다는거다.

그렇다면, 앞서 언급한 기간동안 대체 무슨 일이 있었던 걸까? 어떤 일들이 있었기에 갑자기 이렇게 AMD의 추격이 거세진 것일까? Intel은 AMD의 거센 공격에 어떻게 대응하고 있을까? 소보로빵과 함께 최근 데이터 센터 CPU 시장에서 Intel과 AMD가 어떻게 경쟁해 왔는지, 앞으로의 싸움이 어떻게 전개될 지 살펴보자.

Intel의 시장 지배력이 흔들리게 된 원인은 무엇일까?

Intel Xeon 프로세서는 데이터 센터에서 운영되는 서버 CPU의 표준이었다. 물론 지금도 점유율은 경쟁사 AMD에 비해 압도적으로 높다. Intel은 CPU뿐만 아니라 소프트웨어, 메모리, 네트워크 솔루션까지 아우르는 단단한 생태계를 구축했고, Intel이 제공하는 다양한 솔루션과 개발 도구는 대규모 데이터 센터의 안정성을 최우선으로 여기는 클라우드 시장에서 선도 사업자인 AWS, Microsoft Azure, Google Cloud와 같은 기업들의 신뢰를 얻었다.(클라우드가 무엇인지는 별도의 글에서 자세히 다루겠다.)

클라우드 서비스는 2010년대 이후 데이터 센터 시장의 핵심 성장 동력으로 자리 잡았다. 클라우드 산업의 태동 초기에는 Intel의 Xeon CPU가 클라우드 환경에 최적화된 아키텍처와 기술로 시장을 선점했지만, 클라우드에서 활용되는 워크로드가(애플리케이션, 서비스라고 이해해도 무방하다.) 점점 다양화되고, 클라우드 사업자들은 자신들의 비즈니스가 더욱 확대되기를 원함과 동시에 운영 효율성에도 관심을 두기 시작했다.

클라우드 서비스의 기초는 가상화이다. 이 가상화의 물리 서버 자원을 가상화시켜 빌려주는 것이기 때문에 가상화 기술이 핵심이다. 가상화 기술은 한정된 물리 코어의 수 보다 더 많은 수의 vCPU(Virtual CPU, 가상 CPU를 말하며, 클라우드 서비스 사업자가 빌려주는 CPU 자원을 의미)를 제공해 왔지만, 어쨌든 물리 코어를 활용해야 하는 기술이니만큼, 물리 코어 수가 많을 수록 고객들에게 더 많은 vCPU를 제공할 수 있다.

즉, 코어의 수가 많은 프로세서를 사용하면 같은 수의 서버로도 더 많은 vCPU를 제공할 수 있으니 데이터 센터 운영 비용을 절감할 수 있게 되는거다. 그래서, 클라우드 사업자들의 주된 관심사는 프로세서에 탑재된 코어의 높은 성능보다는, 코어 별 성능이 좀 떨어지더라도 더 많은 수의 코어를 장착하고, 전력 효율도 좋은 프로세서 쪽으로 옮겨가게 되었다.

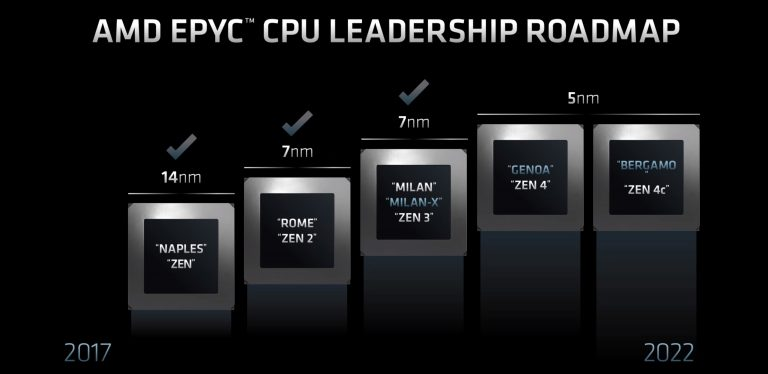

AMD는 이런 변화를 눈치채고 기술 개발에 박차를 가해, 컨슈머 시장에서 좋은 성과를 보인 Zen 아키텍처 기반의 데이터 센터 CPU, EPYC 프로세서를 지속적으로 발전시켰왔다. 2017년 6월에 발표된 AMD 1세대 EPYC Naples 프로세서는 16코어를 지원했지만 Intel Xeon 프로세서의 점유율에 별다른 영향을 끼치지 못했었다. 하지만 2019년에 8월에 발표된 AMD 2세대 EPYC Rome 프로세서부터 상황이 달라지기 시작했다.

Xeon vs EPYC 1차전 개막, AMD의 코어 수를 앞세운 공격은 강력했다

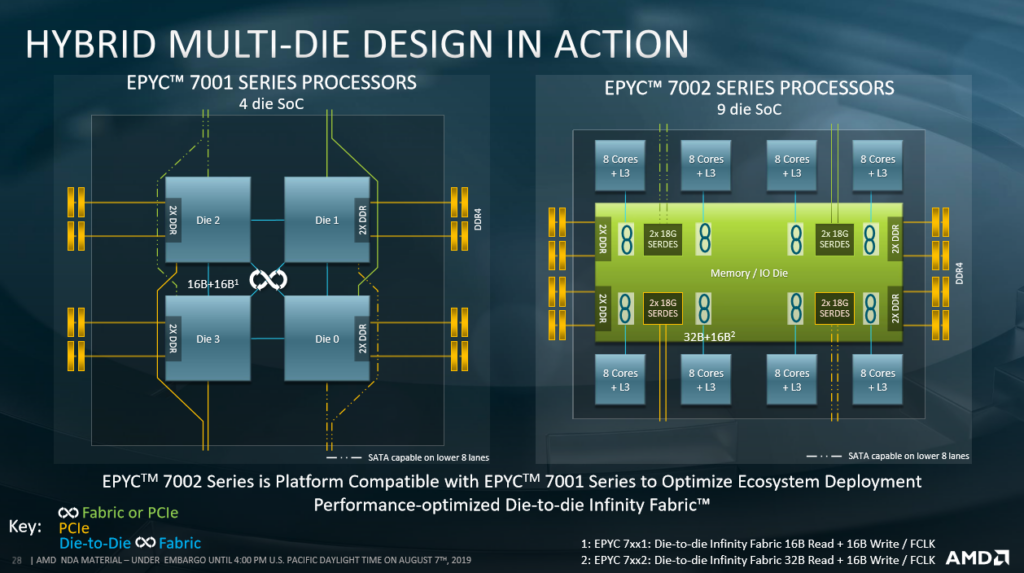

AMD는 1세대 EPYC Naples 프로세서부터 다이(Die)와 다이를 연결하는 칩렛(Chiplet) 기술을 사용했다. 1세대에서는 CPU의 연산(Logic), 메모리, I/O를 하나의 칩으로 만든 SoC(System on Chip) = 칩렛 4개를 사용해 32코어를 구성했다. 칩렛 1개 당 8개 코어를 집적한거다. 하지만 2세대 EPYC Rome 프로세서부터는 메모리와 I/O는 하나의 다이로 모으고, 연산 부분만 개별 다이로 구성하면서 보다 많은 코어를 장착한 프로세서로의 전환을 꾀했다.

위 이미지와 같이 AMD는 연산 다이를 분리해 냄으로써 더 많은 연산 다이(칩렛)를 프로세서에 장착할 수 있게 됐고, 이 두 다이를 서로 다른 파운드리(메모리 + I/O 다이는 글로벌 파운드리 14nm, 연산 다이는 TSMC 7nm)에서 생산한 다음 서로 Infinity Fabric이라는 고유의 인터커넥트 기술을 활용해 총 9개 다이, 1개의 메모리와 I/O가 합쳐진 다이와 8개의 다이(8개 코어와 L3 캐시 메모리를 집적한 칩렛)를 연결해서 총 64코어의 프로세서를 만들었다.

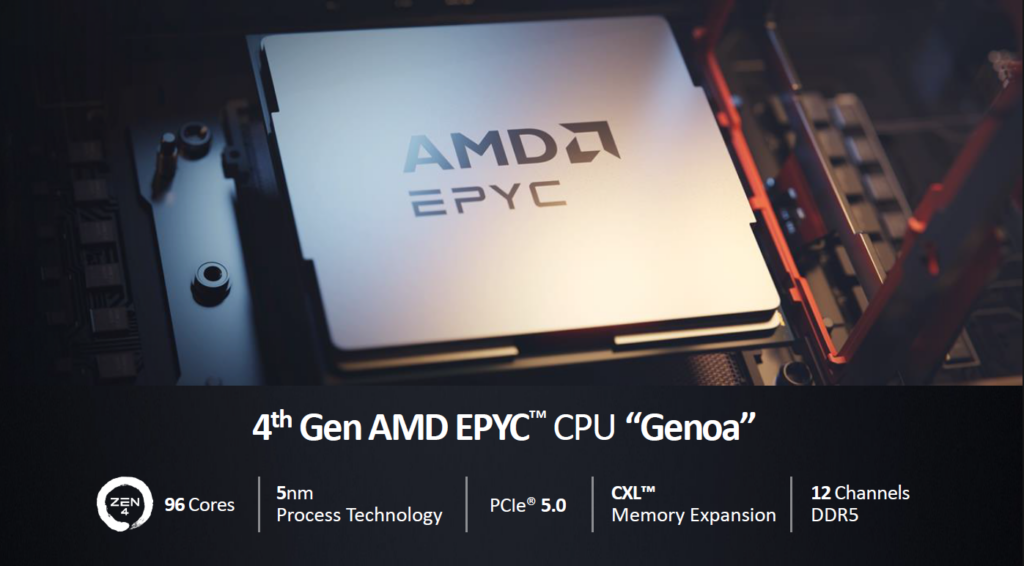

이렇게 탄생한 AMD 2세대 EPYC Rome 프로세서는 최대 64코어에 최대 부스트 클럭은 3.9Ghz, TDP는 고작 280W에 불과했다. 그리고 2년 뒤, 2021년 3월에 출시한 AMD 3세대 EPYC Milan 프로세서는 아키텍처를 더욱 발전시켜 최대 부스트 클럭은 4.1Ghz로 향상됐고 코어 수와 TDP는 같은 수준으로 유지시켰다. 이어 2022년 11월에 출시한 AMD 3세대 EPYC Genoa 프로세서는 코어 수를 96코어까지 늘리며 TDP도 320W로 늘어나지만 여전히 코어 당 전력 효율은 매우 좋은 편이었다.

하지만 Intel은 그들의 전략을 바꾸지 않았다

반면, 이 시기에 공급되었던 Intel의 프로세서를 보면, 2020년 2월 2세대 Xeon 스케일러블 프로세서가 최대 56코어를 지원했지만 이후에 2021년 4월에 증장한 3세대 Xeon 스케일러블 프로세서는 오히려 최대 코어 수가 40코어로 줄어들었고 코어 당 성능 향상에 집중했다. 그 결과 프로세서 성능은 2세대 Xeon에서 3세대 Xeon으로 오면서 IPC 20%, 다양한 워크로드에서 평균 46%의 성능 향상이 있었지만, 앞서 언급한 클라우드 기업들의 다코어 탑재 프로세서 선호 현상으로 인해 조금씩 AMD에 점유율을 잃어버리게 되었다.

정리하면, 이 시기에 Intel은 코어 수를 늘리기 보다는 성능 향상에 집중하며 기존에 자신들이 잘 해왔던, 강력한 서버 성능을 원하는 분야에 알맞은 서버로 발전시켜 왔다면, AMD는 코어 수를 늘리는 데에 집중해서 새롭게 강력한 수요층으로 떠오른 클라우드 기업을 사로잡는 데에 주력했다는 것이다. 그 결과 90% 이상으로 압도적인 Intel의 데이터 센터 CPU 시장 점유율을 AMD가 조금씩 갉아먹는 현상이 벌어지게 되었다고 할 수 있겠다.

Intel의 치명적 실수, 그리고 점유율을 확대하는 AMD

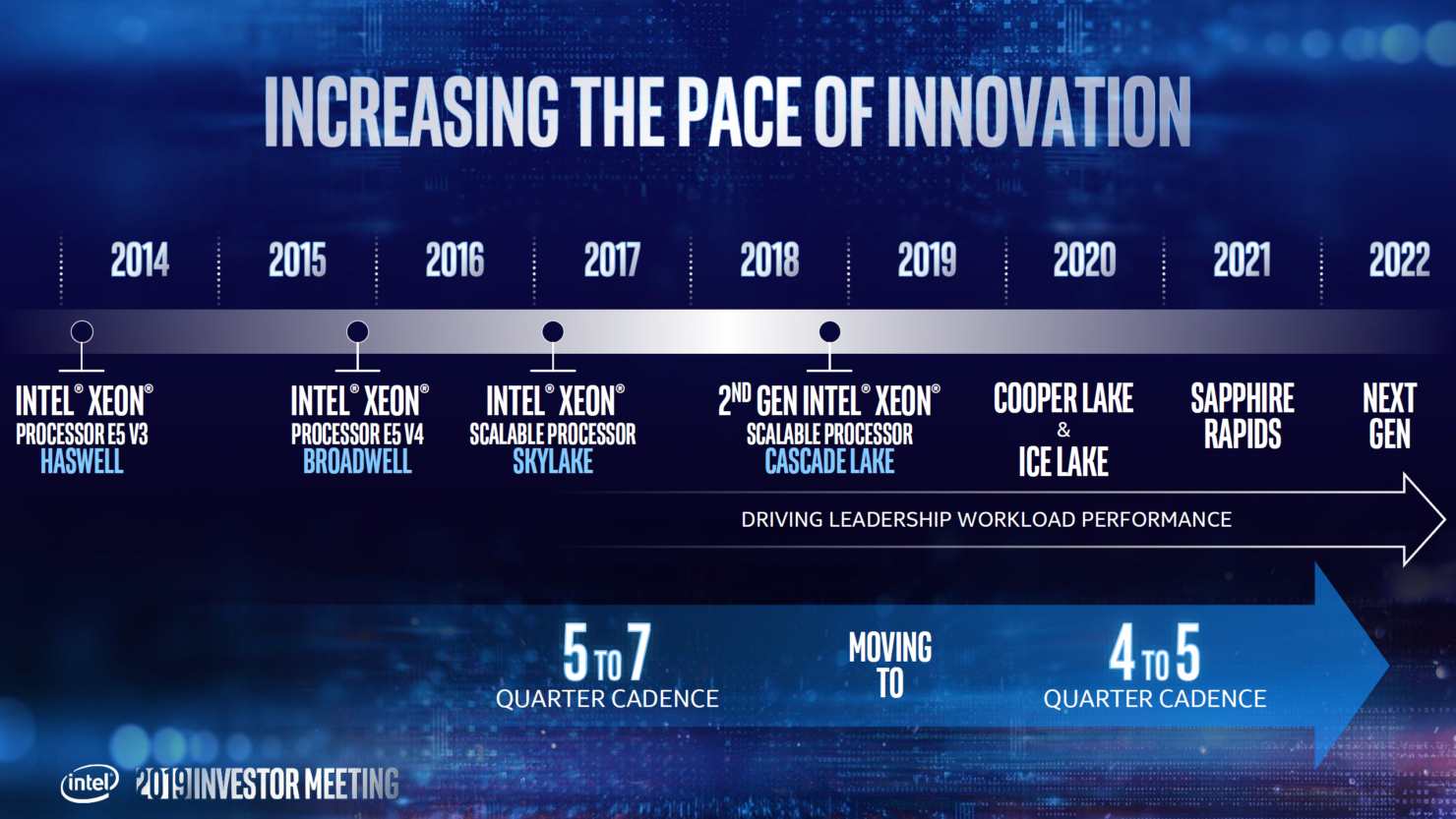

Intel은 2019년 5월에 발표한 Xeon 프로세서 로드맵에서 2021년 4분기에 4세대 Xeon 스케일러블 프로세서, 코드명 Sapphire Rapids(사파이어 래피즈)를 출시하겠다고 발표한다. 하지만 발표한 출시 시기를 맞추지 못했다. 자사의 Intel 7 10nm 공정 상의 문제와 새롭게 시도하는 칩렛 구조의 설계 문제, 그리고 보안 결함 발견 등 프로세서 품질 문제에 봉착해 출시를 여러 번 연기한 것. 그리고 최종적으로 2023년 1월 4세대 Xeon Sapphire Rapids 프로세서를 뒤늦게 출시했다. 예정된 로드맵보다 1년 이상 출시가 늦어진 것이다.

이렇게 Intel의 4세대 Xeon Sapphire Rapids 프로세서 출시가 연기되면서 Intel의 최신 프로세서 도입을 준비하던 클라우드 사업자들과 많은 빅테크 기업들은 자사의 비즈니스 성장을 위한 데이터 센터 확장에 대한 투자를 Intel 때문에 미룰 수는 없다고 생각했을 것이다. 그래서 그들이 선택한 것은 AMD EPYC 프로세서였다. 이미 Intel보다 빠르게 다수의 코어를 장착한, 자신들의 니즈에 알맞은 프로세서를 출시한 AMD의 제품을 시범적으로 도입해서 테스트한 기업들이 많았고, 그들은 Intel의 4세대 Xeon Sapphire Rapids 프로세서 출시 지연을 더는 기다리지 않고 이미 검증한 AMD EPYC 프로세서를 더 많이 도입하기로 결정했다.

2017년 EPYC Naples – 2019년 EPYC Rome – 2021년 EPYC Milan – 2022년 EPYC Genoa로 자사의 로드맵대로 착착 신형 프로세서를 출시해 온 AMD는 제조 공정도 TSMC의 7nm – 5nm 공정으로 발전하면서 더 많은 수의 코어를 장착할 수 있게 되어 최대 96코어의 프로세서를 공급하기에 이른다. 반면 Intel은 AMD EPYC Genoa와 경쟁해야 하는 프로세서인 4세대 Xeon Sapphire Rapids 프로세서가 Intel 7 10nm 공정에서 개발된, 최대 60코어를 지원하는 프로세서였다. 이미 Sapphire Rapids가 출시된 시점에 경쟁사 프로세서와의 코어 수는 26개나 차이가 나는 셈. 이러한 이유로 인해 AMD는 점유율을 더욱 빠르게 늘어나게 된다.

여전히 Intel은 자신만의 길을 고수했다

Intel도 2023년에 뒤늦게 출시한 4세대 Xeon Sapphire Rapids부터 칩렛 구조를 채택해서 다수의 코어를 지원할 수 있게 되었다. 하지만 AMD 대비 공정 세대가 다소 뒤져있다는 평가를 받는 Intel 7 10nm 공정이어서 코어 수를 더 많이 늘리는 데에 한계가 있었다. 이러한 코어 수의 열세를 극복하고자 Intel은 과거 스케일러블 프로세서에 탑재해왔던, 특정 영역의 워크로드 성능을 향상시켜주는 가속기를 Sapphire Rapids에서는 12개로 늘려 적용하면서 차별화를 꾀한다. 이 12개의 가속기 중 중요한 가속기 4개의 특징은 아래와 같다.

Intel 4세대 Xeon 스케일러블 프로세서부터 탑재된 가속 엔진

| QAT(QuickAssist Technology) | DLB(Data Loading and Balancing) |

| 데이터 암호화 및 압축 작업 가속 담당 네트워크, 클라우드에서 암호화된 데이터 처리 효율성 강화 | 데이터를 균등하게 분배하여 CPU 자원 활용 최적화 데이터 로딩 과정에서의 병목 현상 개선 |

| DSA(Data Streaming Accelerator) | IAA(Intel In-Memory Analytics Accelerator) |

| 메모리, 네트워크 간 데이터 이동 최적화 데이터 분석 및 스트리밍 워크로드에서 CPU 부하 감소 | 데이터 분석 작업을 가속해 빅데이터 처리 속도 향상에 특화 데이터베이스 작업 및 실시간 분석에서 효율성 증대 |

이러한 가속기들은 특정 영역에서의 작업을 CPU 대신 처리함으로써 CPU의 부하를 줄여준다. 결과적으로 CPU가 보다 효율적으로 자신이 가진 최대 성능을 최대한 높은 수준으로 발휘할 수 있도록 돕는 것이다. 덕분에 가속기가 활용되는 특정 분야에서의 작업 성능은 Intel이 앞섰지만, 성능 보다는 더 많은 수의 코어를 바탕으로 최대한 많은 VM을 제공하기를 원했던 클라우드 사업자의 입맛을 충족시키기에는 다소 부족해 보인다.

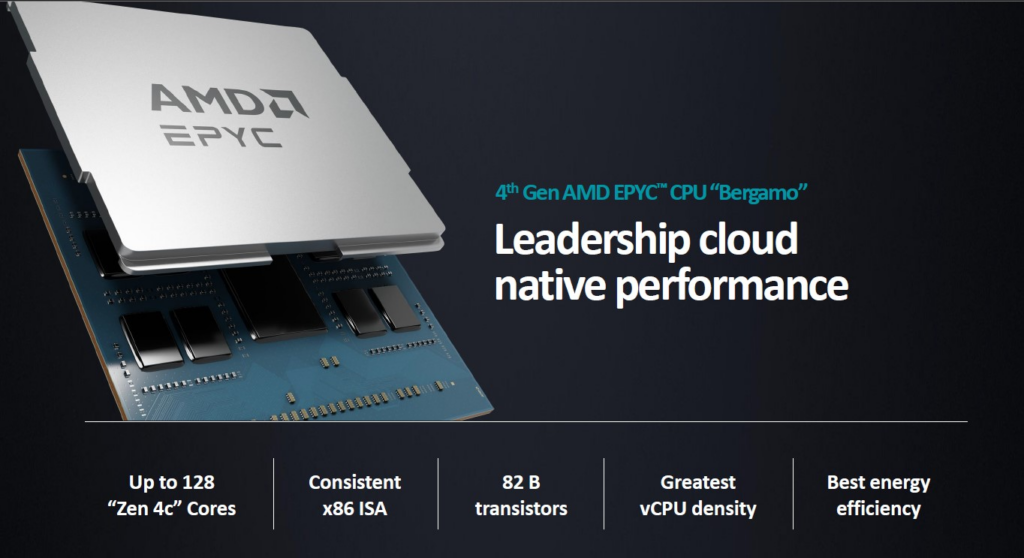

설상 가상으로 데이터 센터 환경은 점점 클라우드로의 전환이 가속화 되면서 일반 기업들도 일부 또는 전부를 클라우드로 전환하기에 이르렀다. 결국, 클라우드의 수요가 지속적으로 확대되면서 클라우드 사업자들은 계속 승승장구했다. 10년 전부터 대세는 클라우드다! 라고 부르짖던 클라우드 사업자의 외침이 비로소 결실을 맺는 모습을 보이자, 데이터 센터 CPU의 트렌드는 확실히 코어를 많이 장착하는 것이 중요하다고 여겨지는 상황이 되어버린 것이라 할 수 있겠다. 이러한 트렌드에 발맞춰 AMD는 클라우드 사업자들을 위해 코어 당 성능은 조금 낮추고 코어 수를 더욱 늘려 최대 128코어까지 지원하는 4세대 EPYC Beramo 프로세서를 2023년 6월에 출시한다.

뒤늦게 코어 수가 중요하다는 것을 깨달은 Intel

그래서 Intel은 발빠르게 다음 세대 Xeon 프로세서를 출시하게 된다. 4세대 Xeon Sapphire Rapids 출시로부터 1년이 채 지나지 않은 2023년 12월, 5세대 Xeon Emerald Rapids(에메랄드 래피즈) 프로세서가 출시된다. 이 때 설계도 대대적으로 변경했다.

기존 4세대 Xeon Sapphire Rapids 프로세서는 15개의 코어를 집적한 칩렛 4개를 연결해 60코어를 구성했지만, 5세대 Xeon Emerald Rapids는 하나의 칩렛에 32개의 코어를 집적해 2개의 칩렛을 연결해 64코어를 구성했다. 덕분에 연결하는 다이가 줄어들어 더 빠른 데이터 전송이 가능해 졌다. 그리고 이 시기에 IT 업계의 가장 큰 화두였던 LLM(Large Language Model) 데이터의 처리 성능이 이전 4세대 Xeon Sapphire Rapids 대비 42%나 향상된다. 4세대 프로세서에 탑재됐던 가속기들의 성능이 5세대 프로세서에서 크게 향상됐기 때문이다.

하지만 최대 코어 수는 여전히 반년 전에 출시한 AMD 4세대 EPYC Bergamo 프로세서의 128코어의 절반 수준이었다. LLM 성능 역시 NVIDIA A100, H100과 같은 별도의 GPU로 처리하는 것이 대세로 자리잡은 만큼, Intel 5세대 Xeon Emerald Rapids 프로세서는 크게 주목받지 못했다.

해외 IT 미디어 Tech Insight에 따르면 2024년 1분기 데이터 센터 CPU 점유율이 Intel 76.3% vs AMD 23.6%를 기록했다고 한다. 이 시기의 AMD의 점유율이 25%에 육박한다는 의견도 많은데, 데이터 센터 CPU의 주도권이 AMD도 가버린 것이 아닌가 하는 우려섞인 전망도 조금씩 나오기 시작했다.

정리하면, Intel의 5세대 Xeon Emerald Rapids 프로세서는 성능과 AI 특화 기능에서의 개선을 통해 4세대 Sapphire Rapids 프로세서의 한계를 극복하려고 했으나 AMD 4세대 EPYC Genoa, Bergamo 프로세서와의 비교에서 코어 수에서 여전히 밀리고 있는 형국이다. 아쉽게도 Intel이 제공하는 다수의 업무 별 특화된 가속기는 클라우드 사업자들의 다수 코어 프로세서 선호 현상을 이겨내지 못한 것 같다. 만약 다수의 코어보다 워크로드 별 성능이 더 중요해 이러한 가속기가 각광받았다면 Intel도 코어 수를 늘리는 전략을 택하지는 않았을 테니말이다.

그래서 Intel은 AMD와의 코어 수 경쟁은 기본, AMD를 넘어서는 기술적 차별화와 전략이 필요하다는 것을 자각했고, 이를 바탕으로 데이터 센터 시장에서의 잃어버린 점유율을 다시 가져오려는 반격을 꾀하게 된다.

반격의 시작, Intel Xeon 6세대 프로세서 출격

Intel은 2024년 6월, 최신 Xeon 6세대 프로세서를 출시했다. 5세대 Xeon 프로세서 출시 이후 6개월 만에 차세대 프로세서를 출시한 것인데, 과거 Xeon 4세대 때와는 다른 기민한 움직임을 보이며 AMD에 반격할 준비를 마쳤다. Xeon 6세대 프로세서의 가장 큰 특징은 아래와 같이 코어 유형을 분류한 것이다.

- Sierra Forest(시에라 포레스트) E-코어(Efficiency Core): 최대 144코어, 전력 효율성이 높고 병렬 작업이 많은 클라우드 데이터 센터에 알맞음

- Granite Repids(그래나이트 래피즈) P-코어(Performance Core): 최대 128코어, 고성능 연산에 최적화되어 AI, 고성능 컴퓨팅(HPC), 대규모 데이터 분석에 적합

Intel은 이렇게 두 가지 유형으로 Xeon 프로세서를 분리하면서 공정도 달리 적용했다. Intel Xeon 6세대 프로세서는 컴퓨트 다이는 최신 Intel 3 3nm 공정에서, I/O 다이는 과거 Intel Xeon 3세대 스케일러블 프로세서부터 Intel Xeon 5세대 Emerald Rapids까지 사용된 Intel 7 10nm 공정에서 생산해 패키징됐다.

그렇다면 Intel은 Xeon 6세대를 빠르게 출시하면서 왜 이렇게 두 가지 유형으로 나눠서 출시 했을까? 그리고 이 각각의 두 프로세서는 어떻게 다르고, 어떤 특징을 가지고 있고, AMD의 공세를 막아낼 수 있을까? 이어지는 글에서 Intel Xeon 6세대 프로세서의 특징을 좀 더 자세히 알아보자.

끝!