지난 글에서 NVIDIA Hopper 아키텍처와 H100에 대해 알아봤었다. 이번 글에서는 NVIDIA H100의 AI 성능이 어느 정도인지, 그리고 H100 GPU가 탑재된 서버에 대해 살펴보려 한다. H100 서버는 크게 두 종류가 있다. NVIDIA가 직접 설계한 서버, 글로벌 서버 제조사들이 NVIDIA H100 GPU를 가져다가 만든 서버, 이렇게 두 종류다.

실제 H100을 도입해 AI 연구에 활용하려는 기업은 보통 H100 GPU만 구입하는 것이 아닌, H100 GPU가 탑재된 서버 자체를 구입한다. 하지만 비용이 무척 비싸기 때문에 섣불리 NVIDIA GPU 서버 기반의 AI 인프라를 구성하긴 어려운 것이 현실이다. 그래서, 이러한 GPU 서버 기반의 AI 인프라를 구성할 때 고려해야 할 것들은 어떤 것들이 있는지도 알아보자.

NVIDIA H100 AI 성능 벤치마크

H100의 AI 성능이 어느 정도인지 알아보기 전에 먼저 이전 세대 GPU와의 스펙을 먼저 비교해 보자. 2016년에 발표된 P100부터 V100, A100, H100으로 진화하면서 공정이 개선되고 트랜지스터 수가 증가했다. 게다가 GPU 클러스터 수, CUDA Core 수, L2 캐시 메모리, Tensor 코어 수, 최대 메모리 크기 등 당연하게도 증가하지 않은 항목이 없다. 특히 바로 직전 세대인 A100과 H100의 스펙을 비교해 보면, CUDA Core 수의 증가폭이 엄청난 것을 알 수 있는데, P100 -> V100 43%, V100 -> A100은 35%인 반면 A100 -> H100은 무려 111%, 2배가 넘게 상승했다.

이러한 스펙 향상을 바탕으로 H100은 직전 세대인 A100 대비 주요 AI 벤치마크에서 어느 정도의 성능 향상을 이뤄냈는지 살펴보자.

먼저 AI 훈련 성능을 보자. NVIDIA H100은 앞서 언급했던 트랜스포머 엔진을 탑재해서 Moe(Mixture Of Experts) 전문가 혼합 모델 훈련에 있어 총 3,950억개의 매개변수 훈련 성능이 NVIDIA A100보다 9배나 빠르다. A100이 7주일 걸리던 것을 H100은 단 하루도 채 걸리지 않은 20시간 만에 완료했다. 단순이 CUDA Core 수 및 다른 스펙이 향상된 것보다 훨씬 더 큰 성능 향상 폭을 기록했는데, Hopper 아키텍처에 채용된 트랜스포머 엔진 덕분으로 봐도 될 것 같다.

NVIDIA는 2022년 7월, 자사가 제공하는 LLM 훈련 최적화 프레임워크인 NeMo Megatron의 업데이트를 발표했다. Nemo Megatron 프레임워크가 포함된 NVIDIA AI 플랫폼은 1,760억개의 매개변수를 가진 오픈 다국어 언어 모델인 BLOOM의 훈련을 담당하며, 현존하는 가장 강력한 언어 모델이자 Microsoft와 NVIDIA가 함께 협업하여 발표한, 자연어 생성 모델, Megatron-Turing NLG를 지원한다.

Megatron-Turing NLG 모델은 최대 5,300억개의 매개변수를 가지는데, 이 모델 학습 시 발행하는 GPU 지연 시간이 H100에서 전 세대인 A100대비 최대 30배까지 향상되어 더 빠른 LLM 모델 개발을 지원한다. ChatGPT에 적용된 GPT 3.5와 같은 LLM 성능을 향상시키기 위해 필요한 언어 모델 학습 및 추론 성능에서 H100이 이전 세대 대비 엄청난 성능 향상을 이룬 것이라고 보면 되겠다.

NVIDIA H100은 HPC 애플리케이션 성능에서도 A100 대비 엄청난 성능 향상을 이뤄냈다. 전자공학에서 소리나 진동, 파형 및 노이즈 분석뿐만 아니라 라이다 센서를 사용한 자율주행 자동차, 대기 분석 및 영상 분석에도 널리 활용되는 3D FFT (푸리에 변환) 성능이 6배 향상됐으며, DNA 염기서열 해독을 통해 개인 DNA 분석 및 질병학에 활용되는 Genome Sequencing 분석 성능이 7배 향상되어 헬스케어 업계의 연구 속도를 크게 개선할 수 있다.

이 외에도 신경망 네트워크를 활용한 딥러닝 모델 중 하나인 ResNet, RNN-T와 자연어 처리를 위한 BERT, 추천 시스템을 위한 딥러닝 모델 DLRM 등 다양한 AI 모델 학습에 있어서 이전 세대인 A100대비 적게는 2배에서 많게는 4.5배 가까이 성능이 향상된 것을 확인할 수 있다.

NVIDIA H100 탑재 서버

이번에는 NVIDIA H100 GPU를 탑재한 서버 종류에 대해 알아보자. 앞서 서두에서 언급했던 것처럼 크게 두 가지인데, 이 두 형태의 서버를 구분하는 기준이 있다. 바로 NVIDIA HGX다.

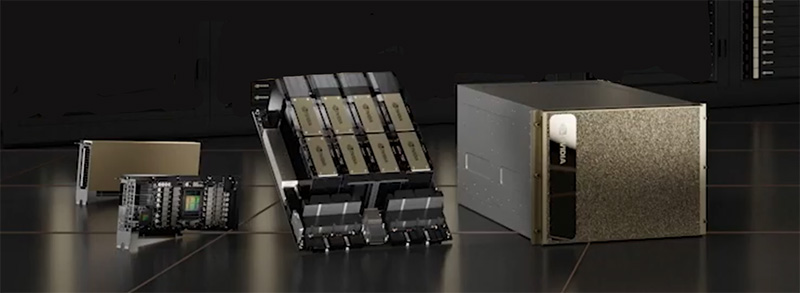

NVIDIA HGX

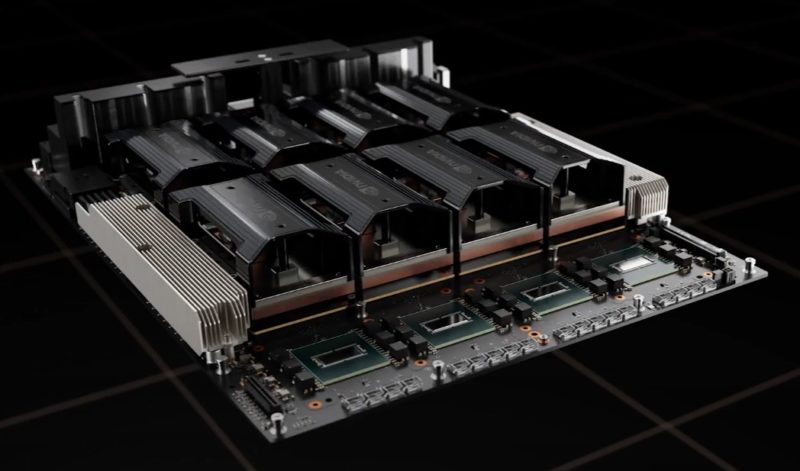

NVIDIA HGX는 NVIDIA가 설계한, H100과 같은 GPU가 4개 또는 8개 장착된 보드다. GPU만 장착된 별도의 메인보드라고 보면 된다. 이 보드를 커다란 6U 또는 8U짜리 서버 안에 넣고, CPU와 메모리를 장착한 메인보드와 NVLink로 연결하는 것이다. NVIDIA는 이 HGX를 직접 활용해 서버를 제조하기도 하고, 서버 제조사들에게 납품해 그들에게 GPU 서버를 맡긴다. 이에 따라 NVIDIA H100과 같은 GPU를 탑재한 서버가 두 종류로 나뉘는 것이다. 이어서 살펴보자.

NVIDIA가 직접 설계한 DGX H100

NVIDIA DGX는 AI와 HPC 작업을 위한 전용 서버다. 앞서 언급한 HGX 보드를 사용해 NVIDIA가 직접 설계한 서버라고 보면 된다. NVLink, NVSwitch를 기반으로 GPU 간 초고속 데이터 통신이 가능함은 물론, NVIDIA가 제공하는 AI에 최적화된 다양한 소프트웨어 스택이 포함되어 있다. 그래서 기업 혹은 연구기관이 NVIDIA DGX 서버를 구매하면, 바로 AI 연구에 활용할 수 있을 정도로 사전에 세팅이 된 상태라고 볼 수 있는 것이다.

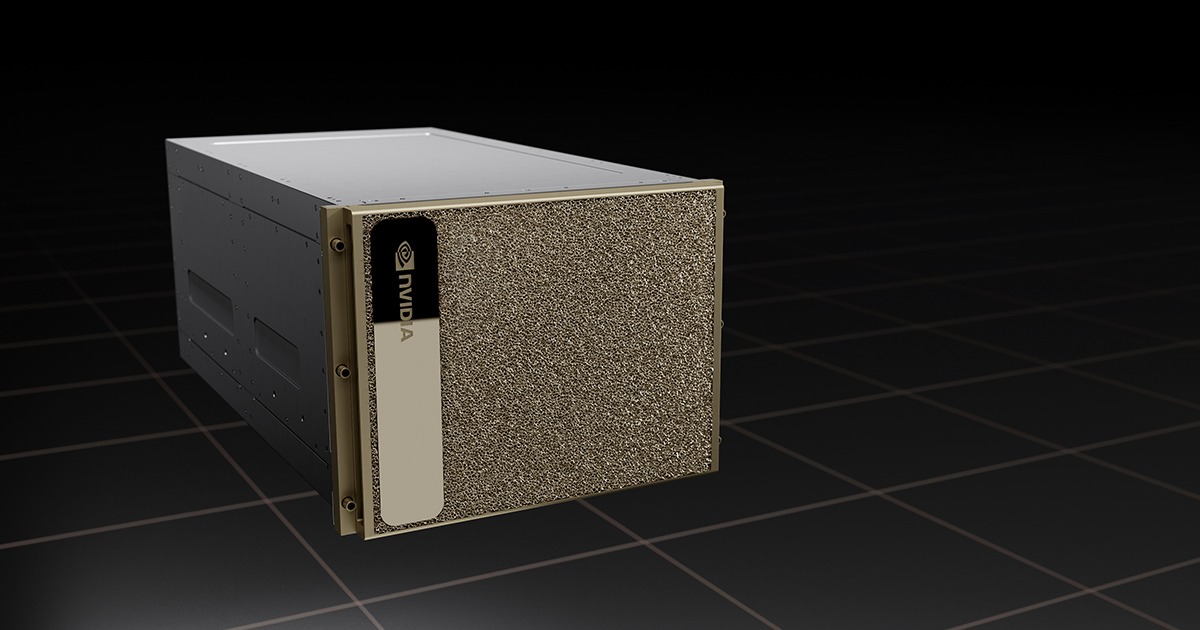

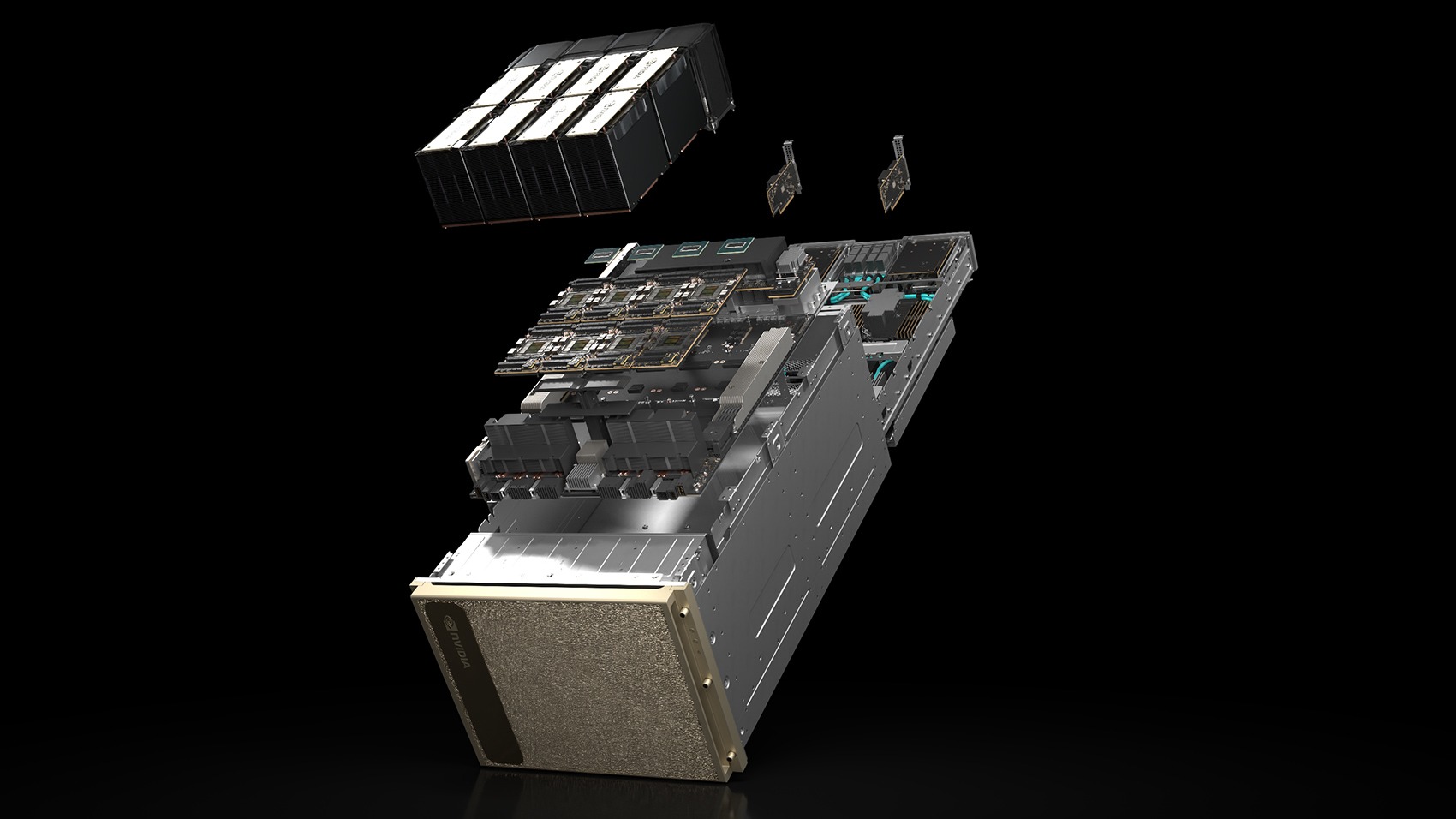

NVIDIA는 지난 Pascal 아키텍처 시절부터 자사의 데이터 센터용 GPU 8개를 탑재한 자체 GPU 서버, DGX 서버를 시장에 공급하고 있다. DGX 서버 역시 GPU 아키텍처가 진화해 가면서 함께 성능이 향상되어 왔는데, 위 이미지는 H100 GPU를 탑재한 DGX H100으로, H100 GPU를 탑재한 서버 중에서는 가장 성능이 좋은, AI를 위한 단일 GPU 서버 노드라고 보면 된다.

DGX H100은 H100 SXM5 폼팩터의 GPU 8개를 NVSwitch 4개로 연결해서 640GB에 달하는 GPU 메모리를 장착했고, 400Gb/s 인피니밴드 네트워크과 200Gb/s 이더넷 네트워크, 3.84TB NVMe 스토리지 8개에 Intel Platinum 8480C 프로세서 2개를 탑재한 8U 크기의 초고성능 서버다. 이전 세대인 DGX-A100 까지는 CPU가 AMD EPYC 프로세서였는데 이번 DGX H100부터 Intel 프로세서로 바뀌었고, 최신 DGX H100은 마찬가지로 Intel의 최신 CPU인 사파이어 래피즈 프로세서가 탑재된다.

NVIDIA DGX H100 SuperPod

앞서 Hopper 아키텍처 부분에서 NVSwitch를 설명하면서 최대 32노드까지 연결할 수 있다고 했었는데, 위와 같이 DGX H100 서버 노드를 1개 랙 당 4대 x 8개 랙 = 32개 노드를 연결하여 총 256개에 달하는 H100 GPU로 구성된 거대한 슈퍼컴퓨터 시스템을 구현할 수 있다. 이것을 NVIDIA는 DGX SuperPOD이라고 부른다.

NVIDIA DGX는 GPU Pod를 더 크게 확장할 수 있다. NVLink 스위치로 8-GPU 서버 32대를 유기적으로 연결해 H100 256-GPU를 연결하면 놀라운 성능에 도달할 수 있는데, FP8 연산 기준으로 1,024 PFLOPS, 조금 더 상징적인 수치로 환산하면 1 EFLOPS(exaFLOPS)에 달하는 연산 능력을 얻을 수 있다. 무려 엑사스케일 급의 슈퍼컴퓨팅 성능을 250여 개 GPU만으로 얻을 수 있는 셈이다.

그리고, DGX BasePOD, SuperPOD 아키텍처 모두 사전에 NVIDIA에서 최적화된 풀스택 플랫폼이라는 것이 가장 큰 특징이다. 하드웨어 스택은 NVIDIA의 고성능 네트워킹 인프라와 DGX H100 GPU, 그리고 NVIDIA 인증 고성능 스토리지로 구성되며, 소프트웨어 스택의 경우 NVIDIA가 특정 산업 및 용도에 맞게 최적화한 AI 애플리케이션 프레임워크를 제공한다. 이 내용을 좀 더 살펴보자.

위와 같이 현재 NVIDIA가 제공하는 AI 애플리케이션 프레임워크 종류는 14개다. 왼쪽부터 제조업의 물리 모델 개발을 위한 MODULS, 헬스케어를 위한 의료 영상에 쓰이는 MONAI, 음성 – 텍스트 간의 변환 기술인 RIVA, 화상회의 및 스트리밍 콘텐츠 개발 가속화를 위한 MAXINE, 대화형 AI 모델 개발에 활용되는 NEMO, 쇼핑몰이나 OTT에서 쉽게 접할 수 있는 추천 시스템 개발을 위한 MERLIN, 물류 및 경로 최적화에 사용되는 CUOPT, 사이버 보안에 활용될 이상 징후 탐지 분석을 위한 MORPHEUS, 가상 세계에 디지털 인간, 캐릭터를 창조하는 TOKKIO, 자체 아바타 제작을 위한 AVATAR, 자율주행 자동차 개발에 활용되는 DRIVE, 로봇 공학 용 ISAAC, 다수의 비디오와 센서 데이터를 활용해 스마트 시티 구현을 돕는 METROPOLIS, 의료기기에서 수집하는 데이터의 실시간 처리를 위한 HOLOSCAN이 있다.

각각의 AI 애플리케이션 프레임워크 이름을 클릭하면 NVIDIA가 제공하는 설명 영상으로 이동한다. 보다 자세한 정보가 궁금하다면 링크로 이동해서 확인해 보기 바란다.

DGX H100은 하드웨어부터 소프트웨어까지, AI 인프라를 위한 모든 것을 AI가 사전에 철저하게 검증해서 제공한다는 것이 가장 큰 특징이다. AI 프로젝트를 시작하려는 기업의 가장 큰 고민은 가장 알맞은 AI 인프라 구축과 소프트웨어 설치 및 세팅에 대한 경험이 부족하다는 것인데, 그들은 AI 모델을 다루는 데이터 과학 분야 전문가이지 AI 모델을 위한 인프라 구축 전문가는 아니기 때문이다. 따라서, 이런 유형의 기업이라면 더욱더 NVIDIA가 이미 검증과 최적화를 끝낸 하드웨어 + 소프트웨어 풀스택 플랫폼인 DGX H100이 제격이라고 할 수 있겠다. 그런데, 문제는 비싸다는 거다. 엄청 비싸다.

서버 제조사들이 만든 HGX H100 서버

NVIDIA HGX H100 보드를 가져다가 서버 제조사들이 자사의 서버 폼팩터에 넣고 만든 서버가 HGX H100 서버다. Dell Technologies, Supermicro 등 글로벌 서버 제조사들이 6U 또는 8U급 고밀도 폼팩터에 Intel 또는 AMD CPU와 메모리를 장착한 메인보드를 구성하고, 이를 HGX H100 보드와 NVLink 또는 PCIe 인터커넥트로 연결한다. 이후 스토리지, 전원 공급 장치(PSU), 고성능 냉각 시스템 등을 통합하여 최종 완성된 서버가 HGX H100 기반 GPU 서버라고 할 수 있다.

NVIDIA는 HGX 플랫폼과 함께 네트워크 카드(예: NVIDIA ConnectX), 소프트웨어 스택(NVIDIA AI Enterprise, CUDA, Base Command 등)도 함께 제공하지만, 서버 자체는 NVIDIA가 직접 설계한 DGX 시리즈와 달리, 각 서버 제조사들이 설계 및 생산하는 것이 차이점이다.

따라서 가격도 NVIDIA DGX 시리즈보다는 상대적으로 저렴한 편이다. 또한, 서버 제조사 고유의 설계 노하우(쿨링, 전원 설계, 관리 시스템 등)가 적용되어 기업 고객들이 실무 환경에서 가장 많이 도입하는 GPU 서버가 바로 이 HGX 기반 서버라고 할 수 있다.

AI 인프라 구성 시 고려해야 할 사항들

지금까지 살펴본 NVIDIA H100 GPU의 성능과 NVIDIA DGX H100, HGX H100과 같은 서버들은 기업 혹은 연구 기관들이 자체적인 AI 모델을 학습하고 추론할 수 있도록 도와주는 핵심 인프라다. 하지만 AI 연구를 위해 반드시 이러한 인프라를 갖춰야 하는 것은 아니다. 대안도 있다. 그럼에도 불구하고 AI 인프라를 구성해야 할 경우, 무엇을 따져보면 좋을 지 알아보자.

AI 모델 학습에 필요한 데이터를 어디에서 관리할 것인가

AI의 성능은 얼마나 많은 데이터를 학습할 수 있느냐, 즉 방대한 데이터 Set을 만들 수 있느냐가 관건이다. 그런데 이 데이터를 자사의, 온프레미스 환경의 인프라에서 보관하고 관리하는지, 아니면 퍼블릭 클라우드에 올려두고 관리할 것인지에 따라 AI 인프라 구성이 달라질 수 있다.

만약, 학습에 사용할 데이터의 양이 많지 않고, 유출되면 절대 안되는 중요한 데이터가 아니어서 클라우드에 두고 관리해도 된다면, 퍼블릭 클라우드 서비스 회사들이 제공하는 AI 학습 서비스를 이용해도 된다. 이미 주요 퍼블릭 클라우드 사업자들이 자사의 AI 학습 서비스에 NVIDIA GPU를 적용한 상품을 출시해서 운영하고 있기 때문이다.

하지만 학습에 사용할 데이터의 양이 많고, 유출되면 큰일인 기밀 데이터가 포함되어 있어 온프레미스에서 데이터를 관리해야 한다면 자체 AI 인프라 구축이 알맞다. 이 때는 NVIDIA DGX 서버나 NVIDIA GPU가 탑재된 대형 서버 제조사들의 AI 서버, GPU 서버를 도입해야 한다.

데이터 과학자가 자주 데이터 학습 실험을 수행하는가

기업에서 보유하고 있는 데이터 과학자가 많지 않다면, 초기 AI 프로젝트 연구를 위해 클라우드 서비스를 활용해 가볍게 AI 모델 학습을 시도해볼 수 있다. 많은 투자 비용을 들이지 않고서 곧바로 AI 모델 연구를 시작할 수 있으니까 말이다.

하지만 위와 같이 생각보다 클라우드에서 GPU가 탑재된 인스턴스를 사용하는 비용이 비싼 편이다. 매월 AI 모델 학습에 넉넉한 비용이 할당되어 있는 것이 아니라면, 데이터 과학자가 이 클라우드 사용 비용이 부담되어 자주 모델 학습을 시험해보지 못하지 않을까? 이렇게 되면, 결국 데이터 과학자가 AI 모델 실험을 제대로 하지 못하게 되는 부작용을 초래할 수 있다.

따라서, 데이터 과학자가 자주 데이터 학습 실험을 하고, 비용에 대한 고민은 잊은 채 오롯이 AI 모델 연구에만 몰두하기 위해서는 자체 AI 인프라 구축이 필요하다. 물론 클라우드보다 초기 투자비용이 높긴 하겠으나, AI 모델 개발은 장기간 연구가 필요한 프로젝트이니만큼, 전체 프로젝트 기간을 놓고 따져보면 총 비용 차이는 크지 않을 것이다. 그래서 이렇게 오랜 기간 AI 연구를 해야 하는 기관, 기업이라면 학습을 할 때마다 비용에 대한 부담없이 마음 편히 AI 모델 실험을 할 수 있는 자체 AI 인프라 구축이 알맞다.

AI 인프라 구성에 드는 시간과 노력이 부담스러운가

데이터 과학자는 데이터 셋을 만들고, 이를 바탕으로 AI 모델을 학습시키고, 최상의 결과물을 내놓을 수 있도록 연구하는 전문가이지, AI 인프라에 최적화된 하드웨어와 소프트웨어 스택을 설치하고 개발 환경을 세팅하는 AI 인프라 구성 전문가는 아니다. 물론 개발자 분들은 AI 관련 소프트웨어에 익숙하겠으나 하드웨어 인프라를 운영하는 IT 운영자들은 소프트웨어 전문 지식이 부족할 수 있다. AI 인프라 구성 및 AI 모델 연구 양쪽 모두의 지식을 가진 데이터 과학자를 확보하는 것은 매우 어렵고, 만약 있다 하더라도 그 데이터 과학자는 AI 모델 연구에만 매진하는 것이 맞다.

게다가, 자사가 개발하려는 AI 서비스의 성능에 알맞은 하드웨어 인프라 사양은 어느 정도인지 파악하고, 소프트웨어는 무엇을 활용해야 하는지 검증하고, 처음부터 알고리즘을 개발해야 한다면 AI 프로젝트의 시작은 그만큼 늦어질 수밖에 없다. 따라서, 기업은 데이터 과학자, AI 개발자들은 오롯이 주어진 AI 인프라 위에서 열심히 연구와 개발에만 몰두할 수 있는 환경을 조성해 주어야 한다.

NVIDIA는 DGX라는, NVIDIA가 철저하게 검증한 하드웨어와 자체 개발한 소프트웨어 및 프레임워크, 그리고 AI 인프라의 핵심인 GPU를 모두 담은 풀스택 플랫폼을 제공하고 있다. 8U 사이즈의 DGX-H100 한대로 AI 프로젝트를 시작한다면 AI 인프라 구성에 들일 시관과 노력을 고스란히 AI 모델 연구에 쏟을 수 있으니 AI 서비스 출시 시기도 앞당길 수 있지 않을까? 그리고, 서비스 출시 이후 보다 많은 사용자를 수용할 필요가 있다면 DGX 서버 노드를 늘려나가면 된다. 어차피 NVIDIA 기반 인프라이기에 규모를 확장한다고 해서 그 때마다 설정을 다시 하는 등의 추가적인 노력 역시 필요하지 않으니까 말이다.

여기까지 두 개의 글을 통해 NVIDIA Hopper 아키텍처의 특징, 그리고 H100 GPU의 성능과 H100 탑재 서버에 대해 알아봤다. 그런데 이 분야에 관심이 있다면 최신 NVIDIA 데이터 센터 GPU 아키텍처인 Blackwell에 대해 들어봤을 것이다. 2024년 3월 GTC 2023에서 발표된 Blackwell 아키텍처는 이제는 이전 세대가 되어버린 Hopper 아키텍처 대비 괄목할만한 성장을 이뤄냈다. 다음 글에서 그 내용에 대해, 그리고 마찬가지로 Blackwell 아키텍처 기반 GPU를 탑재한 서버들을 살펴보자.

끝!

NVIDIA H100 NVIDIA H100 NVIDIA H100 NVIDIA H100 NVIDIA H100 NVIDIA H100 NVIDIA H100 NVIDIA H100