지난 글에서 본격적인 추론 AI 시대를 위한 NVIDIA의 강력한 AI 인프라, Blackwell 아키텍처와 특징에 대해 간략히 다뤘다. 하지만 하드웨어가 전부는 아니다. NVIDIA가 지금의 AI 시대를 주름잡고 있는 주요 요인 중 하나는 강력한 소프트웨어의 힘에 있다. 추론 AI를 위해 NVIDIA가 내놓은 소프트웨어적 해법이 바로 NVIDIA Dynamo다. 그 이야기를 해보겠다.

AI 워크로드에 알맞은 소프트웨어는 따로 있다

기존의 AI 워크로드 운영 환경은 어땠을까?

“예전부터 데이터센터 인프라는 Linux, 그리고 가상화 아니었어?”

맞다. AI 워크로드 역시 Linux에서 돌아간다. 단지 NVIDIA DGX 처럼 전용 인프라를 활용할 계획이라면 베어메탈 환경에서 Ubuntu를 올려 사용하겠지만, 좀 더 범용적인 용도, AI 추론도 하고 HPC 용도로도 사용할 목적으로 GPU 서버를 도입했다면 VMware같은 하이퍼바이저를 올려서 가상화 기반으로 운영할거다.

그런데 여기서 문제가 생긴다. AI 모델은 점점 더 거대해 지고, 추론 요청은 많아지고, 사용자 수는 기하급수적으로 늘어났다. 그런데 이제는 수천 개의 GPU가 실시간으로 협력해야 하고, 사용자의 요청마다 GPU 자원을 ‘한땀 한땀’ 나눠줘야 한다.

그런데, Linux는 왜 GPU가 바쁘게 일해야 하는지 모른다

OS 입장에서는 GPU가 무슨 생각(Pre-fill)을 하고 있는지, 어떤 말(Decode)을 하고 있는지 모른다. 그냥 숫자 몇 개 왔다 갔다 하는 것만 볼 수 있을 뿐이다. 결과적으로 “가상화 기반 Linux 운영 환경으로는 추론 중심의 AI 팩토리 운영이 어렵다”는 현실에 부딪히게 된 것. 그래서 NVIDIA는 새로운 접근을 선택했다

“AI 팩토리는 기존 방식으로는 운영할 수 없다.”

이건 단순한 소프트웨어 이슈가 아니다. 이제는 AI 모델의 동작 흐름 자체를 이해하는 새로운 운영 체계가 필요해진 것이라 할 수 있다. 추론 AI 시대에서 AI 모델은 단순히 문장을 만드는 역할만 하는 것이 아니란 거다. 먼저 문제를 이해하고, 관련된 정보를 수집하고, 생각을 정리한 뒤에야 대답을 한다. 이 과정을 Pre-fill이라 부른다. 그 다음, 그 생각을 ‘말’로 풀어내는 과정을 Decode라고 한다. 즉, 지금의 AI는 ‘읽고, 사고하고, 말하는’ 단계를 매 순간 반복하고 있는 것이다.

그런데 이 흐름은 너무 빠르고, 너무 세밀하다. OS가 개입해서 조율하지 않으면 리소스가 낭비되고, 성능이 반 토막이 나고 만다. 이 문제를 해결하기 위해 NVIDIA가 만든 해답이 바로, 바로 이번 GTC 2025에서 처음 공개한 분산 추론 최적화 프레임워크, ‘Dynamo’다.

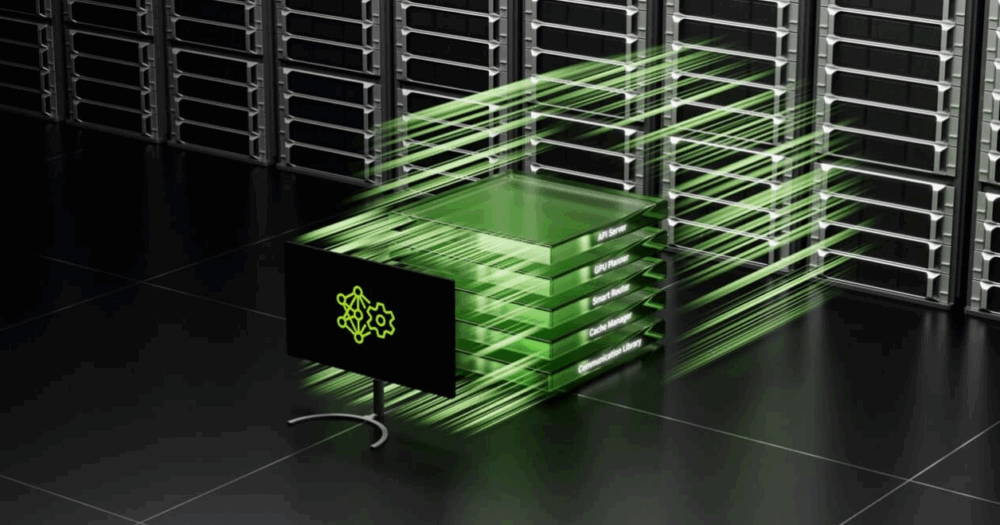

AI 팩토리에 최적화된 분산 추론 프레임워크, NVIDIA Dynamo

Dynamo는 단순한 스케줄러가 아니다. AI 모델이 어떤 타입인지, 어떤 단계에 있는지, 어떤 연산을 하는지까지 이해하고 그에 맞춰 GPU 자원을 실시간으로 재배치해서 분산 처리하는, 고도화된 추론 프레임워크다. 덕분에, 기존엔 GPU에 들어가는 데이터를 컨트롤하지 못했지만, 이제는 KV 캐시까지 직접 관리하면서, 각 GPU가 가장 효율적으로 일하도록 설계할 수 있게 됐다. 뿐만 아니라, Pre-fill과 Decode를 분리해 GPU마다 역할을 다르게 주는 방식도 가능해졌다.

이걸 간단히 정리해 표로 정리해 보면 아래와 같다.

| 구분 | 기존 인프라 운영 방식 | AI 팩토리 운영 방식 (Dynamo) |

|---|---|---|

| 운영체제 | Ubuntu, RHEL 등 리눅스 | 동일 (리눅스 위에 동작) |

| 구조 | 하이퍼바이저 + 리눅스 + 컨테이너 | 리눅스 + Dynamo 프레임워크 |

| GPU 자원 배분 | 수동 스케줄링, 고정 자원 할당 | 실시간 분산 조율, 유연한 자원 배분 |

| 모델 흐름 인식 | 불가능 | Pre-fill / Decode 분리 및 분석 |

| 캐시 관리 | 기본 메모리 계층에 의존 | KV 캐시까지 직접 관리 |

※ 여기서 잠깐, KV 캐시(KV Cache)란?

KV 캐시는 Large Language Model(LLM)이 토큰을 생성할 때 이전에 처리한 Key와 Value 값을 메모리에 저장해두는 캐시다. LLM은 토큰을 하나씩 순서대로 예측하는데, 그때마다 이전에 계산했던 attention 결과를 매번 다시 계산하면 비효율적이다. 그래서 Key와 Value (Transformer에서 Query, Key, Value 중의 Key/Value)를 캐시에 저장해두고, 다음 토큰 생성 시 이전 결과를 재사용해서 계산을 빠르게 하는 게 바로 KV 캐시다.

이걸 왜 NVIDIA가 강조하냐면, 추론 작업을 수행할 때 토큰이 많아질수록 KV 캐시의 데이터도 커지기 때문에, 이 캐시를 GPU 간에 얼마나 효율적으로 실시간 공유하고 분산하느냐가 성능 핵심이기 때문이다. 특히 NVLink를 통해 GPU 간 초고속 통신이 가능해지면서, 이 KV 캐시도 GPU들 사이에서 빠르게 주고받을 수 있게 된 것이라 보면 된다.

Dynamo가 있고 없고에 따라 크게 달라지는 추론 성능

그럼 Dynamo가 실제로 얼마나 효과가 있을까? 위 이미지를 보자. NVIDIA가 공개한 DeepSeek-R1 671B, 그리고 LlaMa 70B 시뮬레이션 결과에 따르면, 동일한 하드웨어 구성에서도 Dynamo를 적용한 환경은 그렇지 않은 환경 대비 최대 30배 이상의 토큰 처리량을 보여줬다.

지난 글에서 본격적인 추론 AI 시대를 위한 NVIDIA의 강력한 AI 인프라, Blackwell 아키텍처와 특징에 대해 간략히 다뤘다. 하지만 하드웨어가 전부는 아니다. NVIDIA가 지금의 AI 시대를 주름잡고 있는 주요 요인 중 하나는 강력한 소프트웨어의 힘에 있다. 추론 AI를 위해 NVIDIA가 내놓은 소프트웨어적 해법이 바로 NVIDIA Dynamo다. 그 이야기를 해보겠다.

지금까지 살펴본 것처럼, AI는 단순히 글을 잘 쓰는 도구가 아니라 ‘추론하고 판단하는 지능형 에이전트’로 진화하고 있다. 이러한 Agentic AI 시대에는 더 강력한 연산 성능과 유연한 데이터 처리 능력, 그리고 이를 효율적으로 운영할 전용 인프라와 그에 알맞은 프레임워크가 필요하다는 것이 NVIDIA의 주장이다. 그리고 NVIDIA는 Blackwell 아키텍처를 중심으로 NVL72 구성, FP4 정밀도, KV 캐시 관리, 그리고 Dynamo라는 AI 팩토리를 위한 맞춤 프레임워크까지 아우르는 풀스택 전략을 통해 AI 팩토리의 새로운 기준을 제시하고 있는 것으로 보인다.

그렇다면 다음 질문은 이거다.

“Blackwell 아키텍처 이후의 미래는 어떤 모습일까?”

“우리는 지금 어떤 기술을 준비해야 할까?”

다음 글에서는 NVIDIA가 그리는 AI 인프라의 미래, 더욱 진화한 Blackwell 아키텍처 기반 GPU, B300과 Blackwell 이후의 아키텍처인 Vera Rubin과 Rubin Ultra로 이어지는 차세대 AI 인프라의 청사진을 살펴보겠다. 추가로, 가상 세계를 넘어 현실로 성큼 다가온, 오픈소스로 공개된 로봇 AI 모델 Isaac GR00T’도 다뤄보자.

끝!