‘미래에는 데이터센터가 AI 공장이 될 것입니다.’

‘TSMC는 반도체 파운드리, NVIDIA는 AI 파운드리입니다.’

2024년 3월에 진행된 NVIDIA GTC 2024에서 젠슨 황 CEO는 새로운 아키텍처 기반의 AI 인프라, 그 인프라에서 사전 학습되어 누구나 손쉽게 가져다 사용할 수 있는 AI 패키지, AI의 종착지인 휴머노이드 로봇 플랫폼을 소개했다. NVIDIA가 단순히 고성능 GPU를 제조하는 기업이 아닌, 전 세계 어느 업종에서든 활용할 수 있는 AI를 만들어내는 공장이 되겠다고 천명한 것. 그리고 이러한 젠슨 황 CEO의 원대한 목표를 이루기 위한 기반이 되는 AI 인프라, 데이터센터 GPU가 바로 Blackwell 아키텍처다.

GTC 2024가 종료된 후 많은 언론과 유튜버, 블로그들이 GTC 2024 키노트 세션을 다뤘다. 그만큼 GTC 2024 키노트 세션에서 발표된 것들이 많은 탓일텐데, 문제는, 정보를 수집하려는 사람 입장에서는 너무 많은 기사와 영상과 글을 읽어야 한다는 것이다. 하나의 기사, 하나의 글, 하나의 영상에서 종합적으로 GTC 2024에서 새롭게 발표된 핵심적인 내용들을 파악하기 어려운 것 같다. 그래서 이번 시리즈를 준비했ㄷ.

앞서 언급했듯, GTC 2024 키노트 세션에서는 크게 AI 인프라, AI 소프트웨어 생태계, 로봇 플랫폼이 소개되었는데, 이 중에서 이번 글에서는 새롭게 발표된 Blackwell 아키텍처에 집중하려고 한다. GTC 2024에서 새롭게 발표된 NVIDIA Blackwell 아키텍처를 지금부터 자세히 살펴보자.

GTC 2024에서 발표된 Blackwell 아키텍처 핵심내용

Blackwell 아키텍처 이름의 유래

NVIDIA의 GPU 아키텍처 명은 항상 유명한 과학자의 이름에서 따오는 전통이 있다. V100 GPU의 Volta는 18세기 ~ 19세기에 활동했던 이탈리아 태생의 물리학자 Alessandro Volta, A100 GPU의 Ampere는 마찬가지로 18세기 ~ 19세기에 활동했던 프랑스 태생의 물리 및 수학자 André-Marie Ampère, H100 GPU는 20세기에 활동했던 미국 태생의 컴퓨터 과학 및 수학자이자 미국 해병대 제독 출신인 Grace Brewster Hopper에서 가져왔다.

그런데 사실 V100의 Volta와 A100의 Ampere 아키텍처 명을 가져온 학자들은 수학보다는 물리학으로 좀 더 유명한 분들이었다. Volta는 전압을 측정하는 단위인 볼트를, Ampere는 전류를 측정하는 단위인 암페어를 의미하니 말이다. 하지만 H100의 Hopper 아키텍처 명을 가져온 Grace Hopper는 컴퓨터 과학자이자 수학자로 매우 유명하다다. 어렸을 때부터 수학에 관심이 많았던 Grace Hopper는 예일 대학교에서 수학 석사 및 박사 학위 취득후 세계 2차 대전 때 미군에 입대, 프로그래밍을 배우면서 컴파일러라는 개념을 최초로 정의했고, 세계 최초의 디버거로서 버그라는 개념을 창시한 분이기도 하다. 그리고 그녀는 프로그래밍 언어의 시조 격인 COBOL(코볼)을 개발했다.

이번 Blackwell 아키텍처의 Blackwell은 20세기에 미국 일리노이 대학에서 게임 이론, 확률 이론 및 통계에 큰 공헌을 한 David Blackwell 이라는 수학자의 이름에서 가져왔다. 키노트 세션에서 젠슨 황은 Davaid Blackwell이 게임 이론에 정통했다는 것을 강조했는데, Blackwell 아키텍처와 GPU 성능을 이야기 하면서 계속 숫자, 수학을 언급했다. 왜 젠슨 황 CEO가 숫자를 강조했는지 아마 키노트 세션을 보신 분들은 잘 알 것이다. 발표 중에 숫자로 된 수치가 정말 많이 나온다.

정리하면, NVIDIA는 새로운 GPU 아키텍처 명을 유명한 물리학, 수학, 컴퓨터 과학자의 이름에서 가져왔고, 이번 Blackwell 아키텍처는 Daivid Blackwell이라는 미국의 수학자 이름에서 따온 것이다 라는 것을 기억해 주기 바란다.

Blackwell 아키텍처 GPU, B200

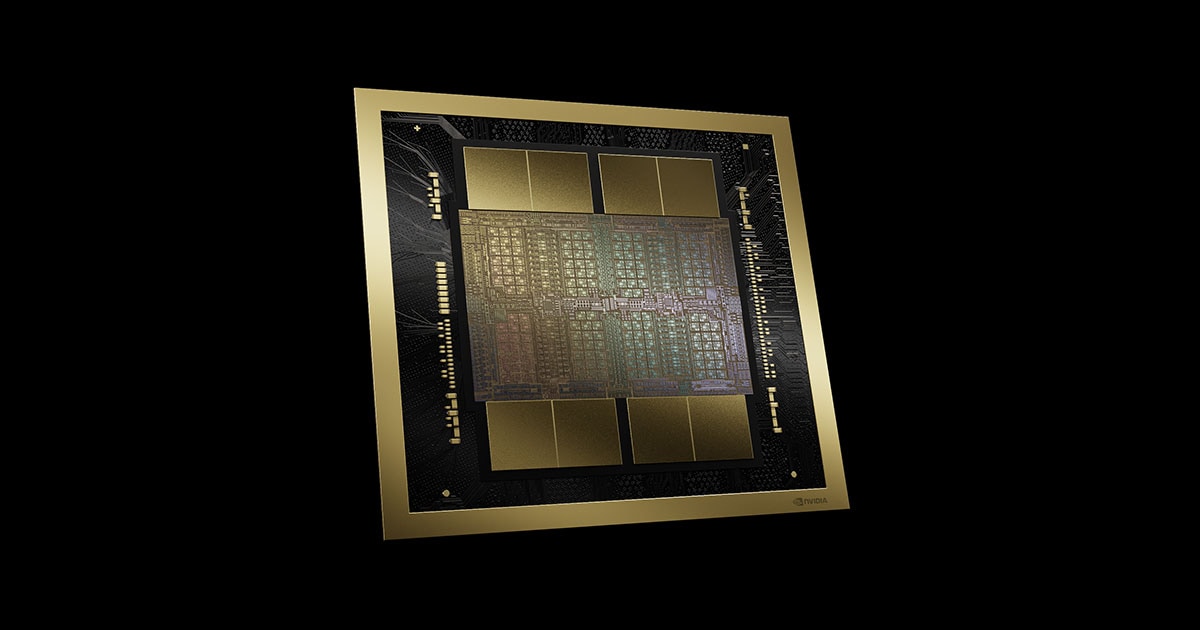

이번 GTC 2024 키노트 세션에서 새롭게 발표된 아키텍처인 Blackwell은 NVIDIA GPU 최초로 MCM(Multi Chip Module) 방식으로 제작된 칩렛(Chiplet) 구조의 칩이다. 이전 세대인 Hopper까지는 1개의 단일 칩에 트랜지스터와 메모리를 집적한 SoC(System on Chip), 모놀리식(Monolithic) 구조였다면, 이번 Blackwell은 1,040억개의 트랜지스터를 집적한 다이(Die) 2개를 서로 연결해 하나의 칩처럼 동작하도록 패키징한 것이다. 그리고 이 2개의 Die 주변에 24GB의 HBM3e 메모리를 상단에 4개, 하단에 4개, 총 8개를 장착해 메모리 용량은 192GB가 되었다.

앞서 언급한 칩렛은 SoC 구조를 극복하기 위해 탄생했다. 반도체 생산 공정에서 중요한 것 중 하나가 수율이다. 아마 미디어에서 TSMC, 삼성전자가 몇 나노 공정을 개발했니, 수율이 얼마니 하는 기사를 많이 접해봤을거다. 최신 공정을 개발했더라도 수율이 나오지 않는다면 NVIDIA나 Apple과 같은 팹리스 기업, 실제 반도체를 생산하지 않고 설계만 하는 기업들의 반도체 수급량이 줄어들어 결과적으로 그들의 제품 생산 단가도 높아지게 된다.

그리고 반도체를 생산하는 파운드리 업체 입장에서도 SoC 구조로 만든 칩의 성능을 높이려면 다이에 더 많은 트랜지스터를 집적해야 하는데, 이렇게 되면 다이의 크기가 커질 수 밖에 없다. 다이가 커지면 반도체 집적회로의 핵심 재료, 원형의 판인 웨이퍼로 만들 수 있는 칩의 수가 줄어든다. 파운드리 업체는 더 많은 칩을 생산해야 수익이 올라가는데 SoC 구조는 성능을 높이기 위해 다이를 키울 수 밖에 없으니 수율이 낮아지고 수익성이 떨어지는 단점이 있는 것이다.

하지만 칩렛은 칩의 기능들을 분리 해 더 작은 크기의 칩 조각으로 따로 만든 다음, 이것들을 나중에 하나의 패키지로 만드는 방식이다. 하나의 큰 칩 안에서 다 박아 넣는 SoC와는 달리, 필요한 기능을 수행하는 작은 칩들을 모아 하나로 패키징하는 구조라고 보면 된다. 처음부터 하나의 다이에 집적하는 것이 아닌, 미리 작은 칩들을 만들어 두고 그걸 나중에 조립한다는 후공정 개념이다. 그래서 다이가 계속 커질 필요가 없다. 일정 크기의 다이에 칩렛 구조로 필요한 작은 칩들을 집적하고, 그 다이를 연결하면 되니까 말이다.

그리고 B200은 이전 세대의 H100과 마찬가지로 SXM 폼팩터를 사용해 8개의 GPU가 하나의 보드에 장착된 HGX B200 보드로 서버 제조사들에게 제공된다. 그럼 서버 제조사들은 그들의 서버 폼팩터에 x86 CPU를 2개나 4개 탑재하고 이 HGX B200 보드를 추가함으로써 6U나 8U 크기의 대형 GPU 서버를 완성할 수 있게 되는 것이다.

그런데 NVIDIA는 HGX B200 말고 HGX B100도 제공한다. B100은 B200과 동일한 스펙, 즉 같은 수량의 트랜지스터와 메모리가 직접되어 있지만 전력 제한을 걸어 성능이 20% 정도 떨어지는 모델로 알려져있다. NVIDIA의 기술 문서에서 확인한 정보를 토대로 살펴보면, B200의 TDP는 1,000W이고 B100의 TDP는 700W임을 확인할 수 있는데, 8개의 GPU가 HGX 보드에 장착되기에 순수 GPU TDP만 HGX B200은 8,000W, HGX B100은 5,600W에 달한다. 여기에 x86 CPU와 시스템 메모리 및 디스크, 기타 다른 부품들까지 더해진 서버 전체의 전력 소모량은 HGX B200이 장착된 서버라면 10KW가 넘을 수도 있지 않을까 싶다.

그리고 하나 더, HGX B100은 기존의 HGX H100이 탑재된 서버와 호환되어 서버에서 HGX H100 보드만 HGX B100 보드로 갈아끼워도 된다고 한다. 즉, 기존에 사용하던 HGX H100 이 장착된 서버에서 GPU 외 나머지 자원을 재활용할 수 있다는 것이다.

CPU 1개와 GPU 2개가 합체! GB200

뜬금없이 이상한 움짤이 나왔지만 다들 잘 아는 장면이라 생각한다. 드래곤볼 후반부에 등장하는 손오천과 트랭크스의 퓨전, 그리고 그 결과로 탄생한 오천크스인데, 단순히 둘의 힘을 합친 것 보다 훨씬 강력한 개체가 탄생했다. 그리고, 이렇게 1 + 1 = 2가 아닌 3이 되는 마법이 드래곤볼 뿐만 아니라 NVIDIA에도 나타났다. 그것도 2년 전에 말이다.

2022년 3월, NVIDIA는 Hopper 아키텍처 기반의 GPU, H100을 발표하면서 또 하나의 제품을 선보였데, 바로 Grace Hopper 슈퍼칩, GH100이다. GH100은 NVIDIA의 Grace CPU 다이와 Hopper GPU 다이를 하나의 기판에 집적하고 이 둘을 NVLink-C2C(Chip to Chip)으로 연결한 제품이다. H100은 별도의 Intel 혹은 AMD의 x86 CPU가 필요하지만 GH100은 NVIDIA가 설계한 AI 작업에 최적화된 Grace CPU가 그 역할을 대신합니다. 그리고 1년 5개월 뒤, 2023년 8월에 H100에 탑재되었던 HBM3 메모리를 HBM3e로 업그레이드한 H200을 발표하고, 이 H200에 Grace CPU가 더해진 슈퍼칩이 GH200이다.

그리고 이 GH200의 기술, Grace CPU와 GPU의 합체는 고스란히 B200에도 적용되었다. 그 결과로 탄생한 것이 바로 2개의 B200과 1개의 Grace CPU가 하나로 퓨전한 슈퍼칩, GB200이다. 이전 세대에서는 1 CPU + 1 GPU였는데 이번 세대는 1 CPU + 2 GPU가 된 것이다. 그런데 B200은 GPU 다이가 2개다. 그래서 이전 세대와 동일 선상에서 비교하면 1 CPU + 4 GPU가 된 셈이다.

GB200의 스펙은 위와 같다. 192GB의 HBM3e 메모리를 가진 B200 GPU가 2개니 메모리도 2배인 384GB를 장착했다. 여기에 72코어를 가진 Grace CPU가 B200 GPU와 NVLink-C2C로 연결되어 최대 900GB/s로 데이터를 주고 받는다. 그결과 성능은 이전 세대인 GH100보다 얼만큼 향사됐을까? 다음 글에서 NVIDIA가 발표한 각종 성능 지표를 통해 GB200의 성능을 가늠해 보자.

끝!